반응형

- regression이란?

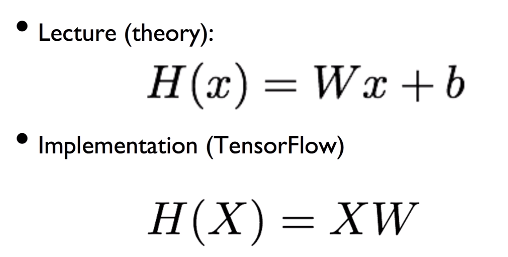

linear regression : H(x) = Wx + b

: 많은 곳에서 적용되는 경우가 많다 ex) 공부하는 시간이 길어질수록 공부를 더 잘하게 됨.

W,b를 알아내야 가설을 알아낼수 있다.

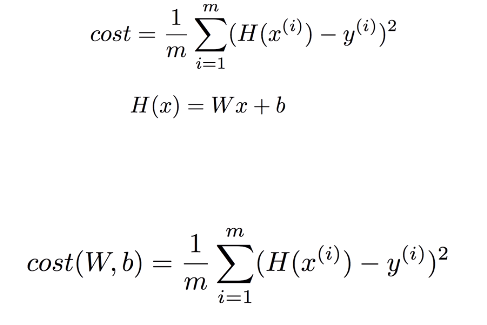

cost function = loss function

우리가 세운 가설 H(x)와 실제 데이터값이 얼마나 차이나는가를 알아본다.

차이가 클수록 더 페널티를 부여하기 위해서 제곱 ( H(x) - y )² 을 많이 사용한다.

결국 cost는 W와 b에 관한 함수가 된다.

linear regression의 학습은 cost(W,b)를 최소화 시키는 W와 b의 값을 구하는 일이다!

cost function은 항상 밥그릇 모양의 convex function으로 최저점이 존재한다.

이 때 많이 사용되는 알고리즘으로 Gradient descent algorithm가 있다.

어떤 점에서 시작하던지 예외가 있긴 하지만 항상 최저점에 도달할 수 있단 것이 이 알고리즘의 장점이다.

알파는 learning rate (ex. 01) 이다.

multi-variable linear regression

실제 구현에서는 WX가 아닌 XW 형태로 H(X)를 표현한다.

Youtube 모두를 위한 딥러닝 참고

반응형

'머신러닝' 카테고리의 다른 글

| Application & Tips (0) | 2019.06.23 |

|---|---|

| axis란? (0) | 2019.06.03 |

| softmax classification (0) | 2019.04.29 |

| Classification (0) | 2019.04.29 |

| Basic (0) | 2019.04.29 |